Wie viele Technologien in der Bildverarbeitung ist 3D-Vision ein Branchen- und Anwendungs-übergreifender Ansatz. Für alle Verfahren in diesem Segment gilt: In der dritten Dimension werden stets deutlich mehr Daten der Prüfobjekte oder Szenen erfasst als mit 2D-Bildverarbeitungssystemen. Im industriellen Umfeld haben diese zusätzlichen Informationen das Potenzial, die Produktivität von Anlagen zu steigern. Außerhalb der produzierenden Industrie ermöglichen sie es unter anderem, aufgenommene Szenen genauer zu beschreiben und somit beispielsweise detailliertere Angaben für Navigationssysteme zu gewinnen.

3D-Bildverarbeitungssysteme decken ein sehr breites Einsatzfeld an möglichen Anwendungen mit unterschiedlichsten Anforderungen ab. Keine aktuelle 3D-Vision-Technologie ist in der Lage, das volle Spektrum dieser Anforderungen optimal und komplett zu lösen. Aus diesem Grund haben sich in der Vergangenheit grundlegend unterschiedliche Ansätze entwickelt, wie man die Erfassung von 3D-Bilddaten angehen kann. Die etabliertesten Verfahren sind derzeit die Laser-Triangulation, Stereovision und Time-of-Flight.

Lasertriangulation

Die Lasertriangulation kann als ältestes Verfahren für die Gewinnung von 3D-Bilddaten bezeichnet werden, für das schon sehr früh industrielle Komponenten verfügbar waren. Dies ist einer der Gründe, warum es heute die weiteste Verbreitung am Markt hat. Der Mess-Mechanismus ist relativ einfach: Eine Laserlinie wird auf das zu prüfende Objekt projiziert und eine in einem bekannten Winkel zum Laser angebrachte Kamera erfasst diese Laserlinie, während Kamera und Objekt relativ zueinander bewegt werden. Höhenunterschiede am Objekt führen zu einem Versatz der Laserlinie, aus dem für jeden Punkt die Höhendifferenz per Triangulation berechnet werden kann. Lasertriangulation ist ein aktives Verfahren, da man die Laserlinie projizieren muss, und es ist zudem ein scannendes Verfahren, da sich Sensor oder Objekt bewegen müssen.

Daraus ergeben sich zwei Hürden für die 3D-Datenqualität: Zum einen verhalten sich Laser in Abhängigkeit vom Material des Prüfobjekts „gut“ oder „schlecht“. Aus Sicht der Bildverarbeitung schwierig sind unter anderem spiegelnde oder schlecht reflektierende Materialien sowie Materialien, in die der Laser eindringt und an anderer Stelle wieder austritt. Abhilfe lässt sich hier nur schaffen durch die geeignete Wahl der Laser-Farbe mit der entsprechenden Empfindlichkeit des Detektors sowie einer geometrisch optimierten Anordnung der Laserquelle zur eingesetzten Kamera.

Das zweite Problem ergibt sich aus der Winkelanordnung zwischen Laser und Kamera, die an steilen Höhensprüngen zu Abschattungen führen kann. An den betroffenen Stellen verdeckt ein Teil des Prüfobjekts die Laserlinie, die sich somit von der Kamera nicht mehr erfassen lässt. Dies führt folglich zu Bereichen, in denen keine Messdaten zur Auswertung vorliegen.

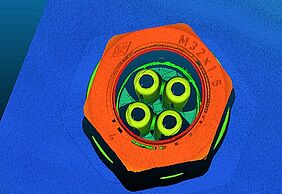

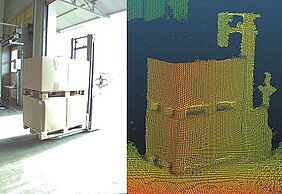

Solche Fälle lassen sich durch den Einsatz von Mehrkopf-Kameras lösen. So verfügt beispielsweise der 3D Laser-Profilsensor Matrox AltiZ über zwei integrierte Kameras, die eine gleichzeitige Betrachtung der Laserlinie mit zwei gegenüberliegenden optischen Sensoren ermöglichen und somit die Gefahr von Lücken in der Bildaufnahme reduzieren. Erfordert die Anwendung eine noch sicherere Erfassung aller Objektpunkte, so kann dies durch ein Setup mit mehreren um das Objekt positionierten AltiZ-Profilsensoren erreicht werden. Geeignete 3D-Software wie z.B. die Lösungen von Matrox ermöglicht dann das Zusammenführen der Daten aller Sensoren zu einer großen Punktewolke. Auf diese Weise lassen sich auch von kompliziert geformten Objekten vollständige Volumenaufnahmen erstellen, um sie für die nachfolgende Bildverarbeitung vorzubereiten.

Stereovision

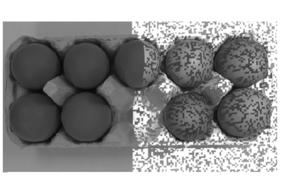

Bei Stereovision-Systemen wird die Tiefeninformation analog zum menschlichen Sehen mit zwei Augen aus zwei Bildern gewonnen, die von zwei in einem bekannten Abstand zueinander installierten Kameras zeitgleich aufgenommenen werden. Aus dieser Vorgehensweise resultieren Bildpaare der aufgenommenen Szene, in denen sich zueinander gehörende Bildbereiche per Mustererkennung identifizieren lassen. Da das gleiche Objekt in den beiden Bildern an unterschiedlichen Positionen abgebildet ist, ergibt bei bekannter Aufnahmegeometrie die Entfernung zum 3D-Sensor.

Stereovision ist prinzipiell ein passives Verfahren, da die Szene nicht beleuchtet werden muss. Das Verfahren eignet sich daher sehr gut für große Szenen und auch für Aufnahmen im Außenbereich. Als Nachteil dieser Methode ist zum einen die benötigte Rechenleistung zu nennen: Das Auffinden der zueinander gehörenden Bildpunkte in jedem Bildpaar macht Stereovision zu einem sehr rechenintensiven Verfahren. Bei vielen Aufgabenstellungen wie beispielsweise in der Roboter-Navigation ist die Echtzeitfähigkeit jedoch eine wichtige Voraussetzung, die sich durch den Einsatz von spezieller Hardware realisieren lässt.

So ermöglichen z.B. die Embedded 3D-Bildverarbeitungssysteme Scarlet, SceneScan und SceneScan Pro von Nerian mit Hilfe eines leistungsstarken FPGA und eines modernen Stereoalgorithmus ein schnelles Echtzeit-Stereomatching der aufgenommenen Bilddaten, die anschließend als 3D-Punktewolke, Tiefenkarte oder 2D-Kameradaten zur weiteren Verarbeitung an das PC-System übertragen werden können.

Prinzipbedingt eignen sich Stereovision-Systeme nicht gut bei homogenen Oberflächen, wo die Software aufgrund der fehlenden Struktur keine Merkmale in den Bildpaaren erkennen und verknüpfen kann. Somit lassen sich für diese Regionen keine Entfernungen berechnen. Durch den Einsatz von Struktur-erzeugenden Methoden wie beispielsweise einem Random-Dot-Projektor existieren jedoch Optionen, um Stereovision auch in eigentlich für diese Technologie schwierigen Fällen anzuwenden.

Time-of-Flight

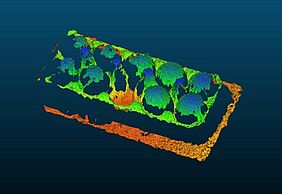

Kameras auf Basis der Technologie Time-of-Flight (ToF) erfassen 3D-Daten auf einem physikalisch anderen Weg: Zunächst wird ein Lichtimpuls ausgesendet, der von einem Objektpunkt reflektiert und von der ToF-Kamera wieder aufgenommen wird. Aus der gemessenen Laufzeit zwischen Aussendung und Empfang des reflektierten Signals kann die Distanz zwischen Kamera und Objektpunkt relativ genau bestimmt werden. Da für jedes Pixel des ToF-Sensors die Laufzeit des kodierten Lichtimpulses gleichzeitig gemessen wird, wird eine dreidimensionale Aufnahmen der untersuchten Objekte erstellt.

Die ToF-Technologie bringt zahlreiche Vorzüge mit sich. Dazu zählt unter anderem, dass die 3D-Daten in einem Schuss vom ToF-Sensor generiert und damit hohe Bildwiederholraten ermöglicht werden. Eine Time-of-Flight-Kamera ist ein fertig kalibrierter 3D-Sensor zur sofortigen Verwendung am Einsatzort. Zudem sind ToF-Kameras sehr kompakt in der Bauform und robust gegen Vibrationen und Schocks, was ihren Einsatz auch an Roboterarmen oder fahrerlosen Transportsystemen zulässt. Einfallendes Tageslicht und Reflexionen können sich hingegen negativ auf die erzielbaren Ergebnisse von ToF-Systemen auswirken.

Ein leistungsfähiger Vertreter der ToF-Technologie ist die industrielle 3D-Kamera Basler blaze. Mit nur einer Aufnahme liefert der integrierte High-End ToF-Sensor IMX556 Sensor von Sony 2D- und 3D-Daten, so dass sich Höhen- und Grauwertinformationen parallel auswerten lassen. Der Sensor und die integrierten Laserdioden der Basler blaze arbeiten bei einer Wellenlänge von 940 nm, ein Bereich, in dem das Spektrum der Sonne eine Lücke aufweist. So ermöglicht die Kamera auch Außenaufnahmen mit einer Auflösung von 640 x 480 Pixeln bei einer Genauigkeit von +/- 5 mm. Einsatzbar ist die Basler blaze für Arbeitsbereiche von 0 bis 10 Metern.

Das ideale 3D-Verfahren

Die drei erläuterten Verfahren zur 3D-Bildaufnahme zeichnen sich durch unterschiedliche Merkmale, Stärken und Schwächen aus. Das „eine ideale“ Verfahren existiert somit nicht, zu unterschiedlich sind die technischen Leistungsdaten, zu verschieden die Anforderungen an die zu untersuchenden Objekte und die Aufnahmebedingungen. Letztendlich haben auch die Kosten wesentlichen Einfluss auf die jeweils optimale Lösung für eine Aufgabenstellung.

Bei Kenntnis der spezifischen Anwendung und deren Anwendungsumgebung ist jedoch eine sinnvolle Auswahl des am besten für vorliegende Aufgabe geeigneten 3D-Verfahrens sehr gut möglich. So eignet sich das Lasertriangulationsverfahren sehr gut für 3D-Präzisionsaufnahmen, um beispielsweise bestückte Elektronikboards exakt zu inspizieren. Stereovision-Systeme sind prädestiniert für die Aufnahme größerer Szenen und werden unter anderem bei Indoor- und Outdoor-Navigationsanwendungen häufig eingesetzt. Die ToF-Technologie spielt ihre Stärken speziell in Logistik-Anwendungen aus, wo aufgrund der hohen Stückzahlen ein starker Kostendruck vorhanden ist, die Messgenauigkeit z.B. bei der Paketsortierung jedoch nicht entscheidend ist.

Mit leistungsfähigen Produkten aus allen drei genannten 3D-Technologien und einer langjährigen Beratungskompetenz aus zahlreichen 2D- und 3D-Bildverarbeitungsprojekten unterstützen die Bildverarbeitungsexperten der Rauscher GmbH Anwender bei der Realisierung ihrer 3D-Vision-Lösungen. Mit ausgiebigen Tests, detaillierten Voruntersuchungen und bei Bedarf auch der Entwicklung von Demonstratoren ermöglicht das Engineering-Team des Unternehmens effektive und wirtschaftliche Lösungen für die 3D-Bildverarbeitung.